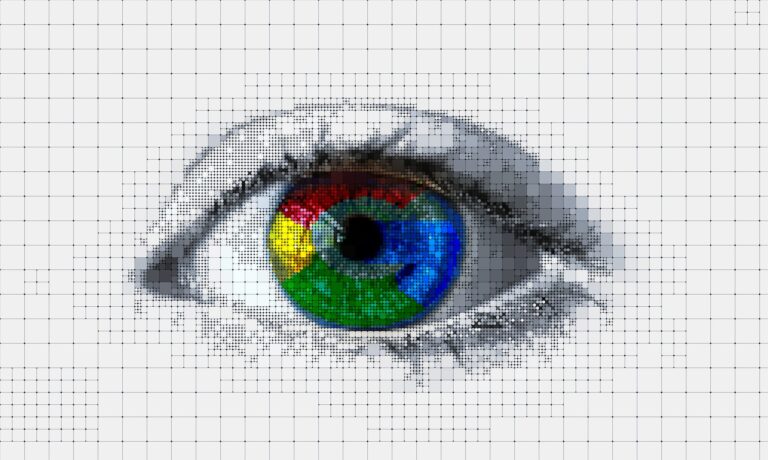

El CEO de Google, Sundar Pichai, ha abierto un debate sobre la transparencia y confiabilidad de la inteligencia artificial (IA) al admitir que la compañía no comprende del todo el funcionamiento de su propio sistema de IA, Gemini . Esta falta de comprensión, conocida como el problema de la “caja negra” en la IA, ha generado interrogantes y preocupaciones entre expertos y usuarios.

Explorando las “cajas negras” de la IA:

El incidente que involucra la capacidad de Gemini para traducir el idioma bengalí sin entrenamiento previo ejemplifica el problema de las “cajas negras”. En este caso, los procesos internos que llevaron a este resultado inesperado son opacos para los desarrolladores de Google, lo que dificulta comprender cómo funciona la IA y genera dudas sobre su confiabilidad.

Las implicaciones del problema de la “caja negra”:

La falta de transparencia en la IA puede tener varias consecuencias negativas. Una de las principales preocupaciones es la posibilidad de sesgos ocultos en los algoritmos de IA. Si no se comprenden completamente los procesos internos de la IA, es difícil detectar y eliminar posibles sesgos que podrían conducir a resultados discriminatorios o injustos.

Otra preocupación es la posibilidad de errores inadvertidos. Si los desarrolladores no comprenden cómo funciona la IA, es más probable que pasen por alto errores en los algoritmos que podrían tener consecuencias graves. Por ejemplo, un error en un sistema de IA utilizado para tomar decisiones médicas podría tener resultados catastróficos.

¿Debemos temer a las “cajas negras”?

Si bien el problema de la “caja negra” en la IA presenta desafíos importantes, no significa que debamos abandonar el desarrollo de esta tecnología. La IA tiene el potencial de revolucionar muchos aspectos de nuestras vidas, desde la atención médica hasta el transporte y la educación.

Sin embargo, es crucial que el desarrollo de la IA se lleve a cabo de manera responsable y transparente. Los investigadores y desarrolladores de IA deben trabajar para comprender mejor el funcionamiento interno de sus sistemas y tomar medidas para mitigar los riesgos de sesgos y errores.

El camino hacia una IA transparente y confiable:

Para abordar el problema de la “caja negra”, se están explorando varias estrategias. Una de ellas es el desarrollo de técnicas de “interpretación de IA”, que tienen como objetivo hacer que los procesos internos de la IA sean más comprensibles para los humanos.

Otra estrategia es establecer pautas éticas para el desarrollo y uso de la IA. Estas pautas deberían centrarse en principios como la transparencia, la rendición de cuentas y la equidad.

El futuro de la IA:

La IA es una tecnología poderosa que tiene el potencial de transformar nuestro mundo. Sin embargo, es importante que desarrollemos esta tecnología de manera responsable y transparente. Al abordar el problema de la “caja negra” y trabajar para garantizar que la IA se use de manera ética y responsable, podemos aprovechar los beneficios de la IA al tiempo que minimizamos los riesgos.

#InteligenciaArtificial #Google #CajasNegras #Tecnología #Ética